반응형

오래전에 어떤 행사에 참여해서 받았던 상품중에

EZFlyer라는 것이 있었습니다.

무려 230MByte의 용량을 자랑하는 녀석이었죠.

CD 없이 이 녀석의 도움만으로 윈도우를 설치한 적도 있었습니다.

(아마 CD 플레이어가 고장난 PC라서 그랬나 싶다는..)

2007/09/16 - [인사이드Dev] - ezflyer 230MB

그리고 몇년이 지나고 이제는 230MByte라는 용량은

작은 비디오클립 하나 담기도 힘든 용량이 되어버렸습니다.

테라바이트급 스토리지 하드웨어도 저렴하게 구할 수 있는 세상이 되어버린거죠.

엔터프라이즈 관점에서 대용량 데이터를 저장할 수 있는 하드웨어적인 문제와 별개로

어떻게 이런 데이터를 처리할지에 대한 고민이 생깁니다.

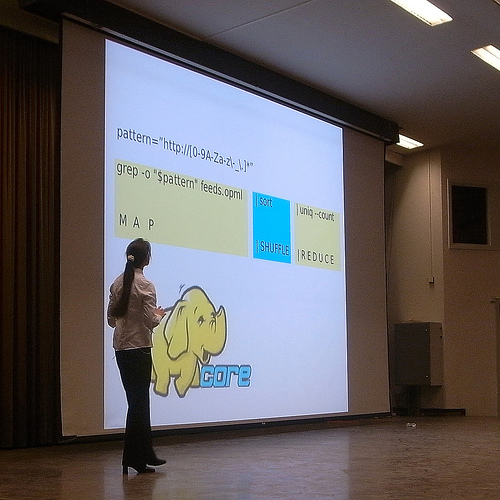

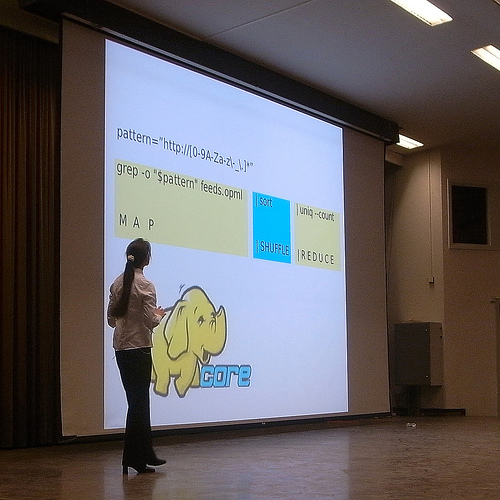

그래서 최근에 Apache Hadoop과 같은 단어를 많이 접하게 됩니다.

최근에 developerWorks에 올라온 내용중에서

Big Data로 새 비즈니스 통찰력 유도하기는 이러한 현상에 대한 전반적인 내용을 집어주고 있으며

http://www.ibm.com/developerworks/kr/library/os-bigdata/index.html

아파치 하둡 맵리듀스 기반 애플리케이션 구현하기 시리즈에서는 실제 어떤 식으로 적용 가능한지를 자세히 설명해주고 있습니다.

https://www.ibm.com/developerworks/mydeveloperworks/blogs/9e635b49-09e9-4c23-8999-a4d461aeace2/entry/274?lang=ko

하둡에 대해 좀 더 알고싶다면 한국 공식 하둡 오픈소스 개발자/사용자들의 모임을 추천해드립니다.

http://www.hadoop.co.kr/

최근에는 활동이 좀 부진하네요. 그외의 자료들은 좀 흩어져 있어서 ...

한빛미디어에서 번역된 책이 한권 있기는 합니다.

http://book.naver.com/bookdb/book_detail.nhn?bid=6280858

시간이 되면 한번 다시 살펴보아야 겠습니다. ^^

EZFlyer라는 것이 있었습니다.

무려 230MByte의 용량을 자랑하는 녀석이었죠.

CD 없이 이 녀석의 도움만으로 윈도우를 설치한 적도 있었습니다.

(아마 CD 플레이어가 고장난 PC라서 그랬나 싶다는..)

2007/09/16 - [인사이드Dev] - ezflyer 230MB

그리고 몇년이 지나고 이제는 230MByte라는 용량은

작은 비디오클립 하나 담기도 힘든 용량이 되어버렸습니다.

테라바이트급 스토리지 하드웨어도 저렴하게 구할 수 있는 세상이 되어버린거죠.

엔터프라이즈 관점에서 대용량 데이터를 저장할 수 있는 하드웨어적인 문제와 별개로

어떻게 이런 데이터를 처리할지에 대한 고민이 생깁니다.

그래서 최근에 Apache Hadoop과 같은 단어를 많이 접하게 됩니다.

http://farm5.static.flickr.com/4008/4344696278_d219685da7_d.jpg

최근에 developerWorks에 올라온 내용중에서

Big Data로 새 비즈니스 통찰력 유도하기는 이러한 현상에 대한 전반적인 내용을 집어주고 있으며

http://www.ibm.com/developerworks/kr/library/os-bigdata/index.html

아파치 하둡 맵리듀스 기반 애플리케이션 구현하기 시리즈에서는 실제 어떤 식으로 적용 가능한지를 자세히 설명해주고 있습니다.

https://www.ibm.com/developerworks/mydeveloperworks/blogs/9e635b49-09e9-4c23-8999-a4d461aeace2/entry/274?lang=ko

하둡에 대해 좀 더 알고싶다면 한국 공식 하둡 오픈소스 개발자/사용자들의 모임을 추천해드립니다.

http://www.hadoop.co.kr/

최근에는 활동이 좀 부진하네요. 그외의 자료들은 좀 흩어져 있어서 ...

한빛미디어에서 번역된 책이 한권 있기는 합니다.

http://book.naver.com/bookdb/book_detail.nhn?bid=6280858

시간이 되면 한번 다시 살펴보아야 겠습니다. ^^

728x90